IT-Infrastruktur kann kalkuliert werden wie jede Commodity. Foto: Pixabay.

Den größten Anteil am IT-Budget haben die Infrastruktur und ihr Betrieb. Die Infrastruktur als größter Kostenblock ist in der Public Cloud viel billiger. Um das zu verifizieren, muss man die eigenen Kosten ehrlich ermitteln. Damit kann man vergleichen, ob der Cloud-Betrieb wirtschaftlicher ist. Oder man sieht, wofür man die Mehrkosten im eigenen Hause aufwenden muss. Ein Gastbeitrag von Jochen K. Michels.

Der Anspruch

Die Kosten des eigenen Rechenzentrums lassen sich mit dem Betriebsabrechnungsbogen des Rechenzentrums präzise ermitteln. Für die IT-Infrastruktur sind die gleichen betriebswirtschaftlichen und kostenrechnerischen Methoden anzuwenden wie für andere Betriebsteile. Auch für die Leistungen gibt es unbestechliche Metriken und Messverfahren, mit denen man auch die Cloud-Anbieter vermessen kann. Wenn beides erfolgt ist, kann man die finanzielle Entscheidung belastbar begründen.

Warum in die Cloud und wann ist es geboten, in die Cloud zu gehen?

Der Cloud-Begriff tauchte vor fast 10 Jahren in der heutigen Bedeutung auf. Vorher war damit nur das Telekommunikations-Netz gemeint. Das Wolkensymbol nutzte man zum Beispiel bei Darstellungen im Bereich Datex-P.

Was man heute damit meint, ist aber immer noch eher wolkig, den Bemühungen des Bitkom-Ausschusses zum Trotz, bei dem wir 2010 versuchten, eine Definition zustande zu bringen. Kurz darauf zählte ein Professor mehrere Dutzend Definitionen der Cloud auf. Da es keine Institution gibt, die – etwa nach Art der Académie Française – so etwas verbindlich definiert, ist bis heute die Bandbreite des Cloudbegriffes groß.

Im Rahmen des IT-Finanzmanagement verstehen wir hier unter Cloud, dass die IT-Infrastruktur eines Anbieters von vielen Kunden nach Bedarf genutzt werden kann – die Public Cloud. Dabei werden die teuren Ressourcen – Spezialisten, Facilities, Hardware, Software, Management – vom Anbieter zentral vorgehalten. Er hat für Verfügbarkeit, Sicherheit, Datenschutz, Aktualität, Wartung, Zugang, Gebäude zu sorgen. Die Anwendungen sind dagegen Sache der Kunden.

Der besondere Vorteil gegenüber dem eigenen Rechenzentrum „on premise“ liegt vor allem in der besseren Auslastung und für kleinere Kunden eben auch darin, dass man die hoch spezialisierten Ressourcen nur anteilig bezahlen muss, statt sie selbst vorzuhalten.

Sobald aber mehrere Kunden einen gemeinsamen Pool nutzen, wird die Frage gerechter Kostenverteilung elementar. Die Abrechnung der Kosten soll verursachungsgerecht erfolgen. Parallelen zur Elektrizität sind zwar offensichtlich, doch ist die Vielfalt der IT-Leistungen deutlich größer als beim Strom. Jedenfalls will man ständig in der Lage sein, die Kosten der Cloud-Nutzung dem – bisher selbst betriebenen oder neu aufzubauenden – eigenen Rechenzentrum gegenüberzustellen.

Im E-Book „Cloud Computing“ des IT-Verlages von Januar 2016 (Gratisdownload für registrierte User) wurden die Methoden und Werkzeuge dargestellt, die man für die Entscheidung „Rechenzentrum – selbst oder aus der Cloud“ benötigt. Diese Kenntnis wird hier vorausgesetzt. Wir wollen sie auf ein konkretes Beispiel anwenden. Dazu versetzen wir uns in die oberste Entscheidungsebene. Wir betrachten die Wirtschaftlichkeit aus Sicht des Eigentümer-Unternehmers. „Was erhalten wir für unser Geld?“ oder „Wo sollten wir investieren?“

Das muss ein einfacher Schritt sein. Komplizierte Berechnungen erreichen die Top-Ebene selten, ihr Interesse noch seltener. Wenn aber der erste Schritt ein Ungleichgewicht auch nur vermuten lässt, kann, ja muss man schrittweise die Genauigkeit erhöhen. Die Unwucht kann entweder im eigenen Controlling über den Zeitvergleich oder im Vergleich mit Marktbegleitern sichtbar werden – am besten mit beiden. Ist sie tatsächlich vorhanden, dann sollte man entscheiden.

Zuerst hier eine Abgrenzung:

Spricht man mit IT-Fachleuten über Cloud, so wird in 95 % der Fälle die Nutzung, Verlagerung oder das Angebot von cloudbasierten Anwendungen genannt. Man denkt in ERP (SAP)-Plätzen, HR-/ Personal- oder CRM(Salesforce)-Nutzern oder auch in hauseigenen Prozessen, die man in der Cloud besser, billiger, sicherer betreiben könne als im eigenen Haus. Das ist natürlich fast immer richtig. Weil man aber einen Aspekt – die Infrastruktur – ausblendet, bleibt ein großes Potential immer noch ungenutzt – warum?

In jeder Anwendung, die man pro Nutzer, Arbeitsplatz, Endprodukt oder nach anderen Kriterien bezahlt, stecken ein Anteil für die Infrastruktur und ein zweiter für die eigentliche Anwendung. Wie groß diese Anteile sind, ist selten bekannt. Nicht einmal der Anbieter weiß das immer genau. Und wenn doch, wird es selten transparent kommuniziert.

Eine alte Weisheit sagt: „Was man nicht kennt, kann man nicht steuern.“

„Man muss es auch gar nicht steuern“, erwidert der Controller oder der IT-Verantwortliche. Denn solange es preiswerter ist als die frühere In-house-Lösung, hat man ja schon gewonnen. Der Wettbewerb zwischen den Anbietern sorge schon für ausreichende Preisoptimierung – so wiegt man sich in Sicherheit.

Der Vergleich mit dem Auto drängt sich auf. Für die Fahrt zum wichtigen Termin, zum Einsatz, zum Krankenhaus, zum Urlaub guckt man nicht auf den Benzinpreis. Allenfalls schaut man sich auf einem der Portale um. Mehr kann man nicht tun, denn die Anbieter-Konzerne kümmern sich ja schon um ihre eigene Kostenstruktur. Sie optimieren die Prozesse der Raffinerie und der Logistik, um an den Tankstellen wettbewerbsfähige Preise zu bieten. Daher sind die Preisunterschiede nicht sehr groß.

Wenn es bei der IT ebenso zuginge, wäre unsere Überlegung überflüssig. Hier zoomen wir also zunächst in die Zusammenhänge hinein:

- Wir betrachten das Rechenzentrum – nicht die Anwendungen

- Vom IT-Budget interessieren nur die Kosten der Infrastruktur – nicht die Kosten der Projekte, der Entwicklung und Wartung von Anwendungen

- Die Kosten des RZ-Betriebes, der Infrastruktur machen weit mehr als die Hälfte aller IT-Kosten aus. Sie sind der „dicke Brocken“

- Von der Software interessiert alles vom Betriebssystem bis zur Oberkante Middleware und der Datenbank – keine Apps

- Ebenso beim Support interessieren auch nur diese Schichten der Hardware und Software – nicht der First oder Second Level für die Anwendungen

Im oben genannten E-Book wurde ab Seite 40 im Beitrag „Cloud-Kostenpotenziale“ bereits das Verfahren erläutert, das in einigen Klienten-Projekten erfolgreich angewendet wurde. Da bei vielen Unternehmen jedoch diese Chancen noch nicht gesehen werden, soll hier nun eine einfache Möglichkeit gegeben werden, diese für das eigene Haus ganz konkret zu ermitteln, vielleicht auch nur probeweise mit wenig Aufwand. Dazu werden zunächst einfache Schritte gegangen. Sobald man erkennt, dass sich der Nutzen abzeichnet, kann man dann jeweils den nächsten machen.

IT-Grundlagen und Technologien der Zukunft

IT-Grundlagen und Technologien der ZukunftMehr zum Thema IT und Digitalisierung lesen Sie im IT-Channel von buchreport und den Channel-Partnern knk und Rhenus. Hier mehr…

Einer im Hause, der IT-Leiter, der CIO oder der Controller, sollte an dieser Aufgabe intensives Interesse haben. Am besten der, der dafür sorgt, dass Computing Power, Diskspace, Zugriffe und interne Bandbreite immer das günstigste Kosten-Niveau haben, um die Anwendungen zu versorgen. Dass diese Perspektive bisher nicht so häufig eingenommen wird, mag daran liegen, dass die Margen einfach viel zu auskömmlich sind. Wie ein IT-Leiter mir kürzlich sagte: „Uns geht es eigentlich zu gut.“ Sollten Sie, ähnlich wie dieser, einen Handlungsdruck gar nicht verspüren, so lesen Sie bitte nicht weiter.

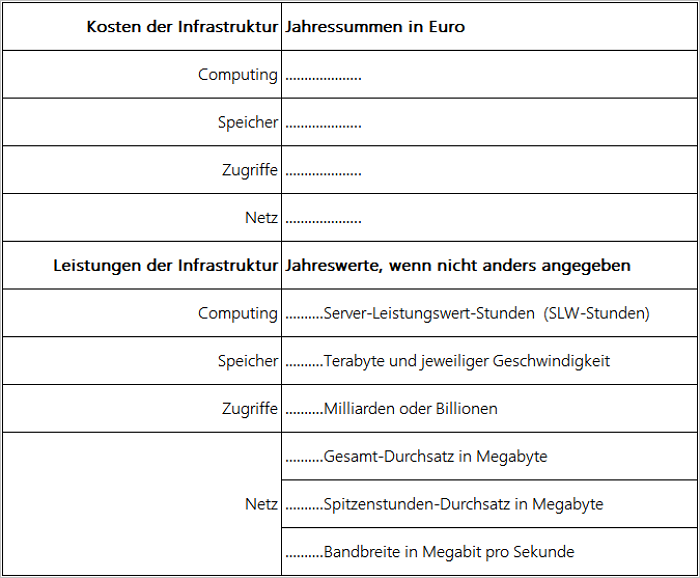

Es kommt darauf an, Kosten und Leistungen der Infrastruktur

- genau zu erfassen und regelmäßig zu überwachen

- mit Standards zu messen und zu vergleichen, welche (a) die Vergleiche mit alternativen Anbietern ermöglichen. (b) auch den Vergleich mit anderen Nutzern – Peers – erlauben

- so transparent zu zeigen, dass die eigenen Nutzer dies gern akzeptieren und nicht auf den Gedanken kommen, woanders arbeiten zu lassen.

Für die Leistungen genügt es zunächst:

- die Computing Power – die Leistungskapazität – aller Rechner zu ermitteln

- eventuell auch noch deren Arbeitsleistung zu erfassen

- für die Speicher deren Kapazität und die Geschwindigkeit zu erheben

- das gleiche auf die Speicherzugriffe (I/Os) anzuwenden

- für das Netz im Rechenzentrum die Bandbreite zu erfassen, evtl. noch den Datendurchsatz

Wenn eine grobe Schieflage herrscht, wird das jetzt auffallen. Es genügen diese wenigen Parameter. Da es sich um Commodities handelt, ist der Preis alleiniger Maßstab. Die genormte Vergleichbarkeit lässt keinen Raum für Abweichungen. Zu hohe Preise für gleiche Leistungen sind durch nichts zu begründen. Enorm niedrige oder hohe Preise für die standardisierten Leistungselemente deuten auf gravierende Fehler hin. Diese können im Einkauf, in der Kostenrechnung oder beim Management liegen. Um das festzustellen, ist die nächste Stufe, die In-depth Präzisierung, nötig.

Kosten

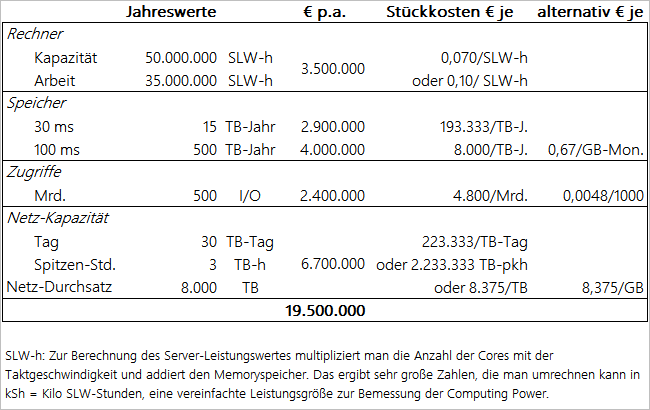

Für die Kosten zieht man am besten die IT-eigene Kostenstellen-Gliederung heran. Wenn die nicht existiert, muss sie erst geschaffen werden, wie ebenfalls im oben genannten E-Book beschrieben wurde. Am Ende hat man für jede der vier genannten Leistungen auf den vier zuständigen Kostenplätzen deren jährliche Gesamtkosten, zum Beispiel (alles in € oder USD):

- Rechner 3,5 Mio.

- Speicherkapazität und -Leistung 6,9 Mio.

- Zugriffe 2,4 Mio.

- Netz 6,7 Mio.

Damit beläuft sich das gesamte Infrastruktur-Budget auf 19,5 Mio. Das IT-Gesamtbudget mag bei ca. 30 Mio. liegen. Durch einfache Divisionskalkulation erhält man die spezifischen Kosten. Dies reichen für unsere Aufgabenstellung in erster Näherung aus. Denn sie lassen unmittelbar erkennen, wo es eine Unwucht geben könnte, bei der man tiefer ins Detail gehen muss.

Nun müssen außerdem noch die Leistungsmengen ermittelt werden.

To-Dos:

Leistungen und Kosten der IT-Infrastruktur werden wie Energieverbrauch oder Logistik präzise erhoben.

Sie werden mit dem Markt und anderen Peers verglichen.

Die finanzielle Entscheidung für „make or buy“ folgt zweifelsfrei. Wenn für das Eigenhosting entschieden wird, kennt man die Opportunitätskosten.

Leistungen

Schaut man sich die Leistungen genauer an, so bietet vor allem die Computing Power oft eine Herausforderung, weil es hierfür keine marktweiten Standards gibt. Es existieren stattdessen fast nur herstellereigene Maßstäbe (Benchmarks). Die sind leider untereinander nicht vergleichbar. Daher wurde in der Zeitschrift „IT-Management“ bereits vor einigen Jahren der Server-Leistungswert (SLW) vorgeschlagen. Herstellerunabhängig ist damit die Leistungskapazität jedes Rechners im Handumdrehen festgestellt und das mit einer Genauigkeit, die für das Finanzmanagement der IT ausreicht.

Schwieriger ist es mit der Arbeitsleistung, d. h. wie lange (in Stunden, Minuten, Sekunden) jeweils mit welchem Prozentsatz die Nenn-Kapazität des Rechners tatsächlich zur Arbeit genutzt wurde. Da es bisher keine wirtschaftlich sinnvolle Methode gibt, dies für Server genauso zu messen wie für Mainframes, hilft man sich gerne mit begründeten Schätzungen (educated guesses), gestützt durch Multimoment-Aufnahmen oder Intervallmessungen der Systemlast.

Die Mengen-Ergebnisse sehen dann zum Beispiel so aus:

- Computing Power: Kapazität 50 Mio. SLW-Stunden, Arbeit 35 Mio. SLW-Stunden

- Speicherplatz: 15 TB Kapazität mit 30 ms, 500 TB mit 100 ms

- Speicherzugriffe: (I/Os) 500 Mrd.

- Netz-Bandbreite: 1.000 MB/sec = 86,4 TB/Tag

- Netz-Datendurchsatz: 30 TB/Tag, Spitze 3 TB/Stunde

Produktionsumsatz

Stellt man nun die ermittelten Kosten je Kostenplatz den hier festgestellten Mengen gegenüber, so sieht man in der folgenden Tabelle

dass die tatsächlich genutzte Arbeit aus der Rechnerfarm 10 Cent pro SLW-Stunde kostet, während die vorgehaltene Rechenkapazität – auch wenn sie das ganze Jahr über leerlaufen würde – pro SLW-Stunde 7 Cent kostet. Nun kann man den Kunden beides alternativ oder ergänzend berechnen, sollte es aber nicht gleichzeitig tun. Näheres dazu in IT-Management: „Endlich ein Urmeter fürs Computing“, Jan-Feb 2010 S. 32 ff.

Beim Speicher fallen für die schnellen Medien je Terabyte für ein Jahr € 193.000,- für die langsamen nur € 8.000,- je TB an. Den Kunden berechnet man natürlich viel kleinere Einheiten, zum Beispiel € 0,67 für ein GB je Monat. Verhandlungssache bleibt, ob man dem Kunden nur den belegten oder auch den vorgehaltenen Platz berechnet, selbst wenn er nicht belegt ist. Für den schnellen Speicher ist der Preis naturgemäß höher, aber die Methodik die gleiche.

Die Zugriffe kosten € 4.800,- je Milliarde oder € 4,80 je Million oder € 0,0048 je 1.000.

Die Bandbreite im internen Netz des Rechenzentrums ist eine vorgehaltene Kapazität. Die tatsächlich pro Stunde oder Sekunde geleistete Arbeit – also die übertragenen Mega- oder Terabyte – wird selten festgehalten oder weiterberechnet, weil die Schwankungen groß sind und die Vorgänge sehr schnell ablaufen. Allenfalls misst und verrechnet man die pro Tag, Woche oder Monat insgesamt übertragenen Daten. In unserem Beispiel sind die Kosten zum Beispiel mit € 2,3 Mio.je Peak-hour-Terabyte optisch sehr hoch. Daher berechnet man besser den Durchsatz mit € 8,40 je durchgesetztes GB und kommt bei der Jahresmenge von 8.000 TB auf den gleichen Erlös von € 6,7 Mio.

In der Spalte rechts werden alternativ noch einige populäre Preisstellungen gezeigt.

Vergleichen Sie diese hier beispielhaft gezeigten Mengen und Preise, kommt es eventuell zu einem ersten Schock. Wenn Ihre Kosten im eigenen Rechenzentrum on premise ganz anders aussehen, kann die Überraschung groß sein. Oder die Kostenplätze, Kostensummen, Produktionsmengen, Produktbezeichnungen lauten ganz anders. Das ist keine Seltenheit, weil es Standards oder Normen nicht gibt, ebenso wenig wie einen Kostenplan oder Kontenrahmen für die IT oder auch nur für die IT-Infrastruktur. Zwar wurden diese im Arbeitskreis „IT-Dienste-Abrechnung“ für die Beteiligten erarbeitet. Doch haben noch längst nicht alle Betreiber von IT-Infrastruktur diese umgesetzt.

Daher bieten wir hier an, zunächst die einfachen Grunddaten auszuwerten und diese bei Bedarf schrittweise zu verfeinern. Dazu können Sie die folgenden Fragen einfach beantworten und vertraulich einsenden. Um zusätzliche Vertraulichkeit zu erreichen, können Sie Ihre Angaben auch mit – nur Ihnen bekannten – Faktoren umrechnen. Sie müssen dann allerdings auch die Ergebnisse in gleicher Weise „rückübersetzen“, damit Sie vollen Nutzen daraus ziehen. Sofern die Euro-Beträge Ihnen nicht schon vorliegen, empfiehlt sich der Aufbau eines Betriebsabrechnungsbogens für das Rechenzentrum.

Die eingegangenen Angaben werden mit Kennbuchstaben anonymisiert. Nur dem Einsender wird dieser mitgeteilt. Die Angaben werden monatlich ausgewertet und allen Einsendern anonym und vertraulich mitgeteilt. Zunächst wird nur eine einfache Gegenüberstellung mit Kennziffern erstellt.

In Abstimmung mit den Teilnehmern kann eine Vertiefung mit mehr Details durchgeführt werden, zum Beispiel nach Größenklassen, Branchen oder auch speziellen Eigenarten der Infrastruktur. Wenn die beteiligten Firmen eine genügende Sicherheit der Analyse erkennen, können sie auf diese Weise die Cloud-Entscheidung auf belastbare und dauerhaft gültige Informationen stützen. Das gilt gleichermaßen für die Verlagerung oder das Behalten im eigenen Hause.

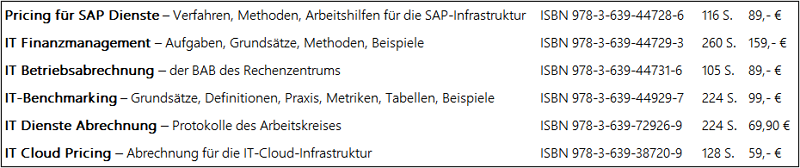

Zur weiteren Vertiefung bietet der Autor seine folgenden Bücher:

Inhalte zu den Büchern findet man auf www.jomi1.com unter „Publikationen“.

Dipl.-Ing. Jochen K. Michels ist selbständiger Unternehmensberater und berät seit 1975 Klienten mit Schwerpunkt IT-Finanzmanagement aus unternehmerischer Sicht. In Analysen, Vorträgen, Büchern und Fachbeiträgen äußert er sich zu verschiedenen Bereichen des IT-Finanzmanagement. Seit 2010 kamen Aufgaben als externer Datenschutzbeauftragter hinzu.

Fotos: Pixabay, Autor.

Kommentar hinterlassen zu "IT-Infrastruktur: Lohnt sich die Cloud?"